Lutte à la

désinformation

Authentifier une image,

sortir du site et

information scientifique

En plus de ses trucs de base,

le Détecteur de rumeurs vous propose ces quelques astuces de pro!

Quel serait votre premier réflexe ?

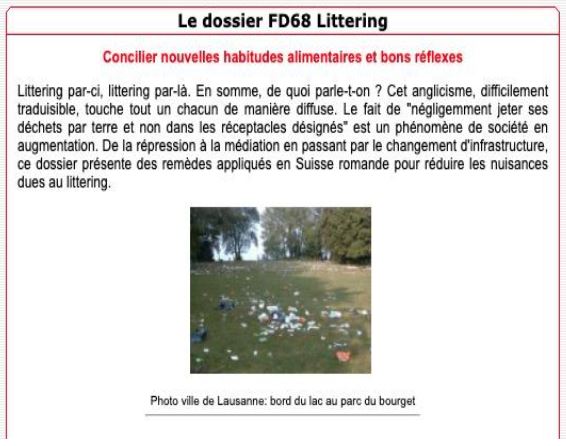

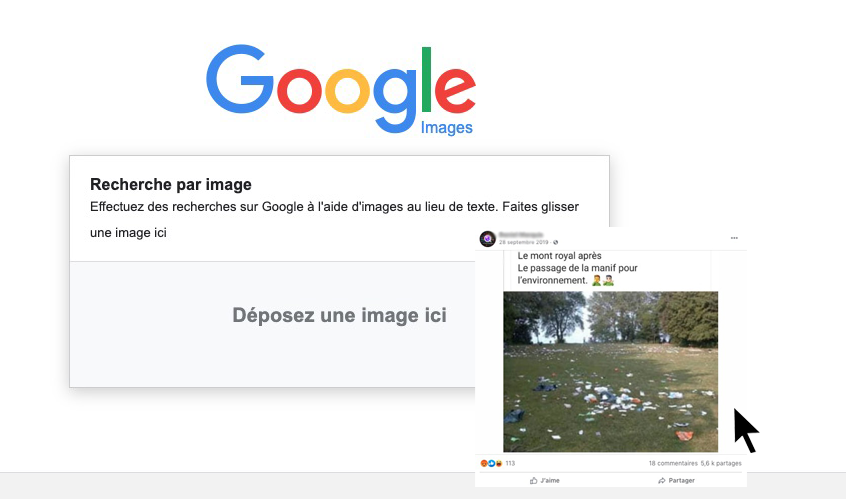

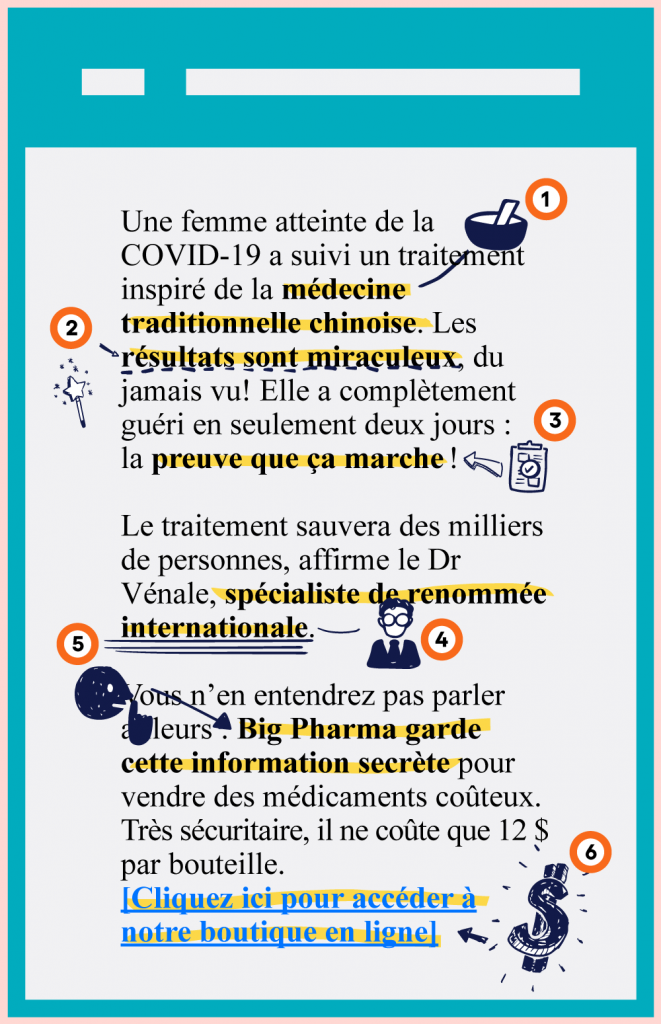

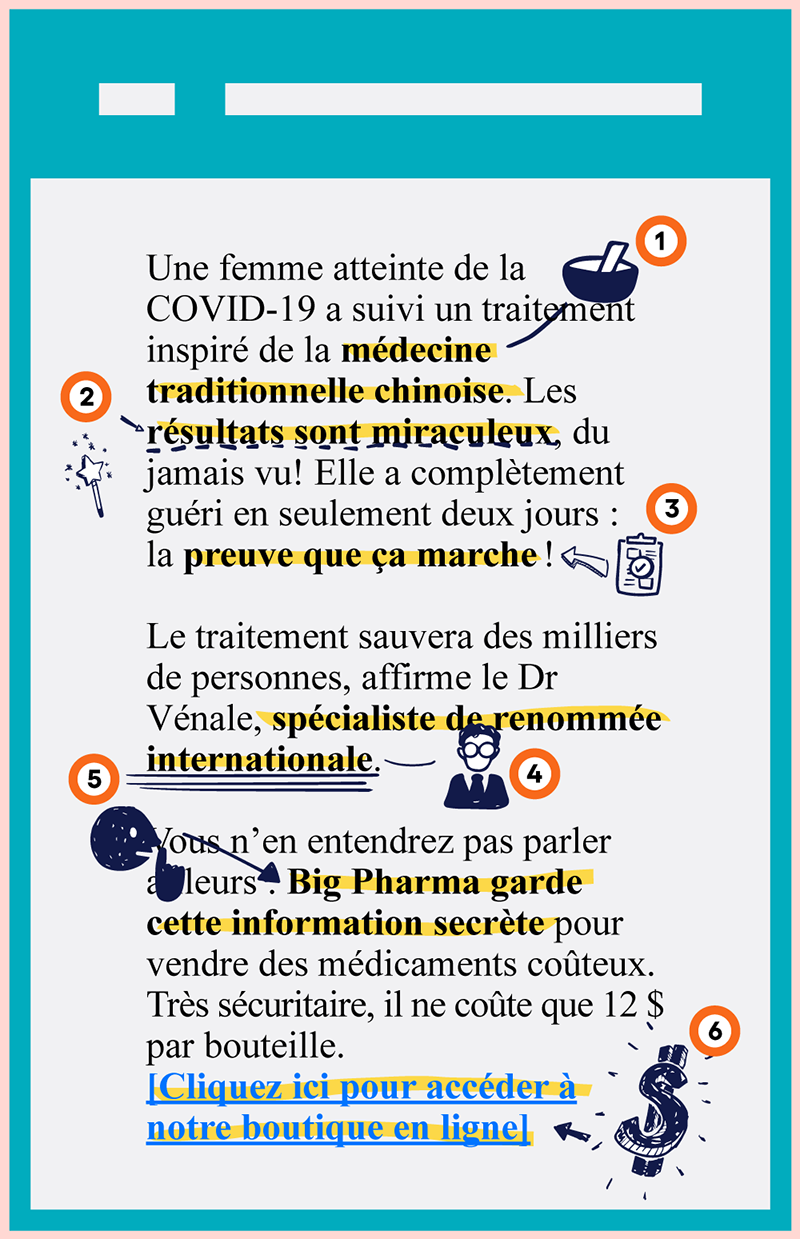

Faire dire à une image ce qu’elle ne dit pas

Comment authentifier une image?

Le Détecteur de rumeurs prend toujours soin d’observer les images et porte attention aux détails (vêtements inappropriés pour la saison, ombre bizarre, cadrage serré qui empêche de bien voir le lieu, etc.).

Il fait aussi une recherche inversée dans Google Images. Les résultats montreront si le visuel douteux a été publié ailleurs, dans un autre contexte.

Sortir du site!

Les journalistes vérificateurs de faits passent leurs journées à valider ou à démentir des informations.

Leur premier truc pour vérifier une nouvelle : il faut sortir du site qui les publie pour faire des recherches plus poussées !

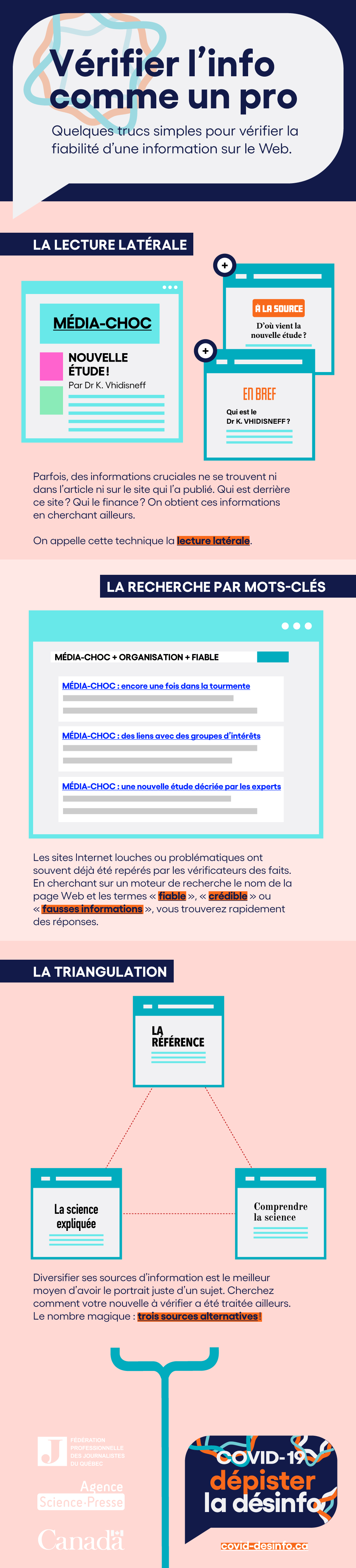

La lecture latérale

- Qui est derrière ce site?

- Qui finance ce site?

- Qui est l’auteur?

- Etc.

Pour aller plus loin

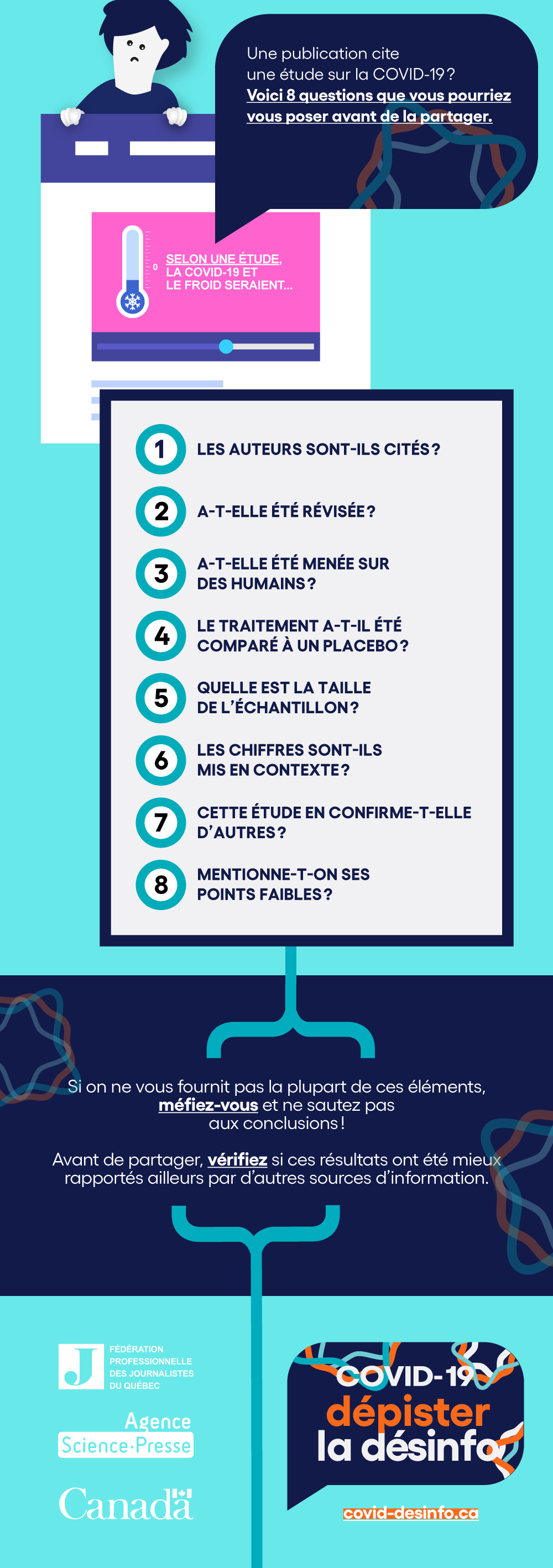

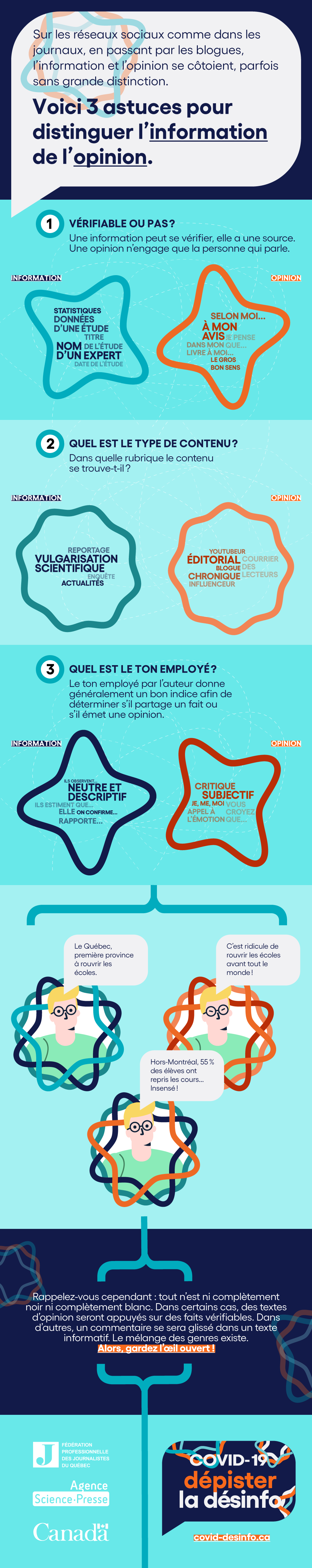

Comment vérifier la crédibilité d'une information en science?

Peut-on vérifier une information qui s’appuie sur de la science si l’on n’est pas soi-même scientifique? Oui!

Par exemple :

Un scientifique est-il cité?

Une vague affirmation que « des chercheurs affirment » ceci ou « des études disent » cela devrait susciter la méfiance.

Si un scientifique est cité, a-t-il publié des résultats?

D’autres experts pourront les lire, les analyser et vérifier s’ils sont solides — ou s’ils comportent des erreurs.

Est-ce que le scientifique présente des faits ou son opinion sur un sujet?

Les faits sont vérifiables et incontestables alors qu’on peut être en accord ou non avec une opinion.

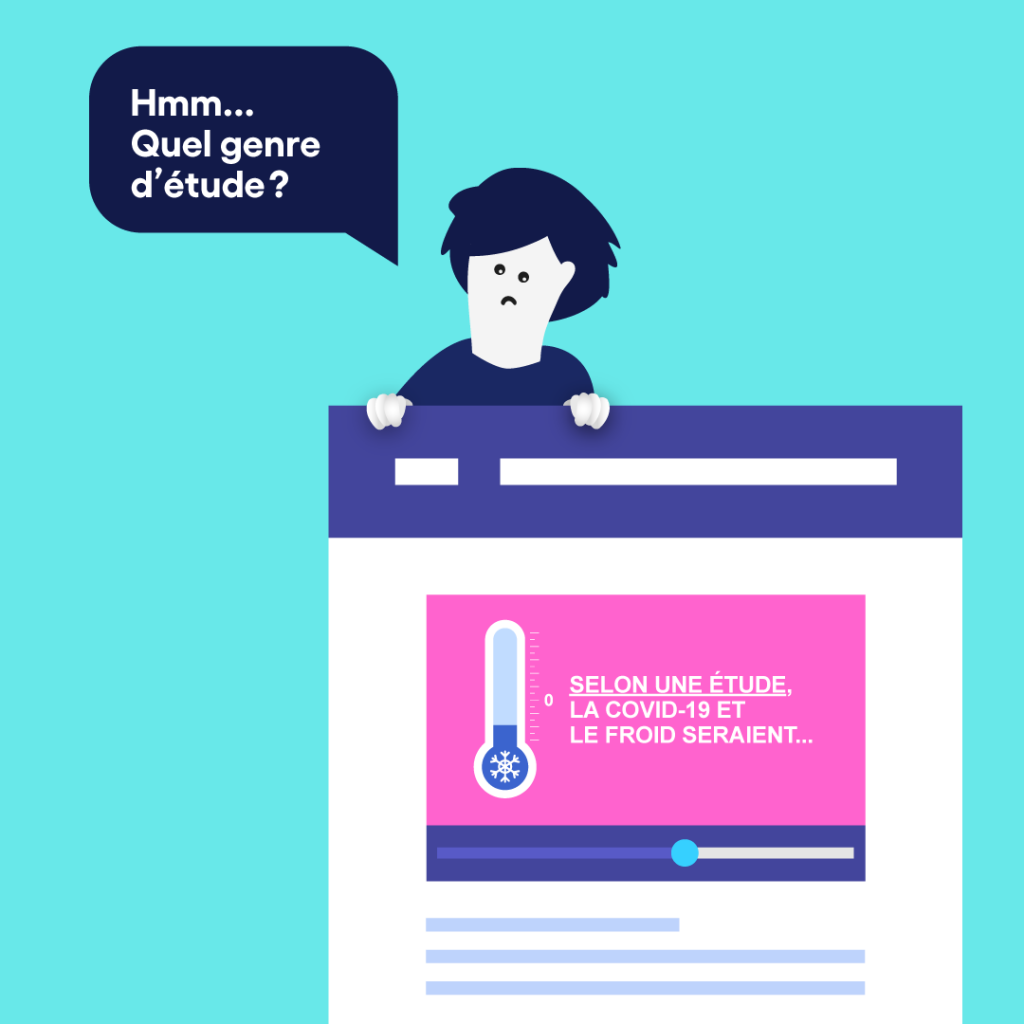

Toutes les études n’ont pas la même valeur

S’agit-il d’une expérience sur des souris ou sur des humains?

S’il s’agit d’une étude sur des humains, quel était l’échantillonnage?

Est-ce une méta-analyse?

Pour aller plus loin

Pour aller plus loin

En conclusion

Certaines nouvelles demandent parfois un peu plus de temps à vérifier. Mais ces quelques astuces plus avancées du Détecteur de rumeurs devraient vous permettre d’y voir plus clair et vous éviter de tomber dans les pièges les plus fréquents!

Pour aller encore plus loin

- Vous êtes enseignant ou enseignante? Voyez toutes nos nos fiches pédagogiques

- Vous voulez entendre des journalistes vérificateurs de faits? Voyez notre série #VraimentVrai – Comment vérifier l’information

- Vous préférez de courtes vidéos? Voyez notre série Anatomie des fausses nouvelles et sa petite soeur Anatomie des fausses nouvelles | Politique

- De courtes vidéos pour les jeunes? Voyez notre série Vérifié

- De courtes vidéos humoristiques (mais sérieuses)? Notre série Déjouer les raccourcis mentaux avec Louis T

- Vous cherchez des articles de vérification des faits? Visitez la section du Détecteur de rumeurs

Inscrivez-vous à un de nos ateliers de formation!

Lutte aux fausses nouvelles : un enjeu de société

Continuez vers les autres parcours thématiques!

Abonnez-vous à notre infolettre!